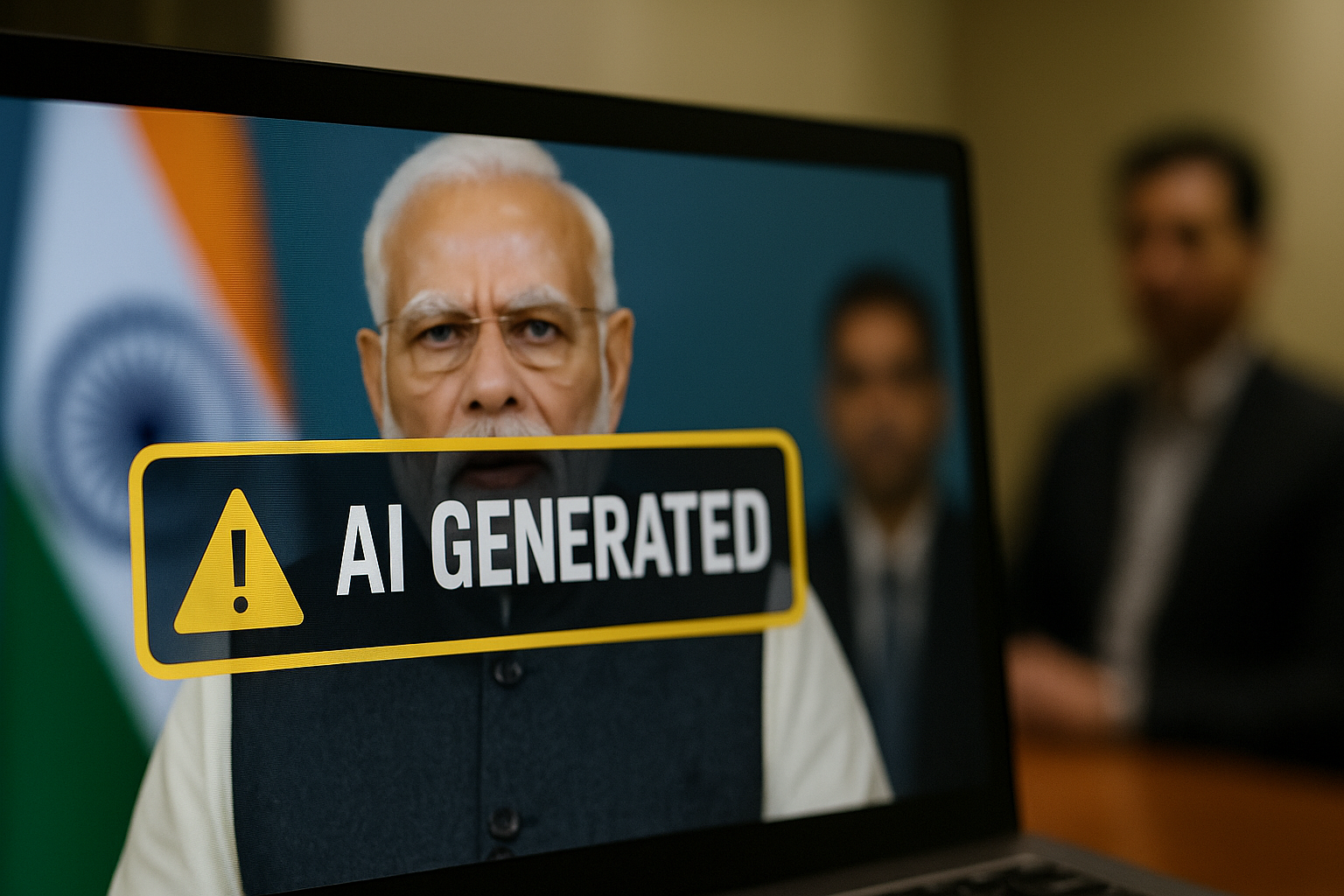

Nuova Delhi propone un pacchetto che impone etichette visibili sui contenuti generati dall’intelligenza artificiale, dichiarazioni obbligatorie degli utenti e tracciabilità via metadati.

Nuova Delhi prepara una legge pionieristica che impone etichette visibili sui contenuti generati dall’intelligenza artificiale. Obiettivo: frenare la disinformazione, prevenire i deepfake e ristabilire fiducia nell’ecosistema digitale di un Paese da quasi un miliardo di utenti. Una mossa che potrebbe cambiare gli equilibri globali tra tecnologia, politica e verità.

Perché l’India interviene adesso

C’è un motivo preciso per cui l’India ha scelto questo momento per agire. Negli ultimi anni il Paese ha vissuto un’ondata di deepfake e contenuti manipolati che hanno attraversato WhatsApp, Facebook e X come una febbre virale. Video politici falsi, dichiarazioni inventate, immagini di celebrità mai scattate: tutto questo ha iniziato a erodere la fiducia dell’opinione pubblica in modo silenzioso ma profondo. In un Paese dove la rete è spesso la prima e unica fonte di informazione per milioni di persone, la manipolazione digitale diventa una minaccia diretta alla coesione sociale.

Agire, per il governo indiano, significa riconoscere che l’intelligenza artificiale non è più un tema da conferenze o startup, ma una forza culturale capace di alterare la percezione collettiva. Ogni deepfake diffuso in rete, anche solo per gioco, può trasformarsi in miccia politica o in falso giudizio. L’intervento regolatorio, quindi, non è solo un gesto di controllo: è un tentativo di ricostruire un patto minimo di fiducia tra ciò che vediamo e ciò che accade davvero.

L’architettura della proposta: visibilità, dichiarazioni, metadati

Il cuore del disegno di legge è tanto tecnico quanto simbolico. Ogni contenuto generato da un’intelligenza artificiale dovrà essere accompagnato da un’etichetta visibile che copra almeno il 10% della superficie di un’immagine, oppure i primi 10% di un audio o video. In pratica, la trasparenza diventa parte integrante dell’esperienza visiva.

Ma non basta una scritta: la norma prevede anche che gli utenti, nel momento in cui caricano un contenuto, dichiarino se questo è stato creato o modificato da un sistema di IA. È un modo per responsabilizzare chi pubblica e per costruire un percorso di tracciabilità a monte. A completare il quadro ci sono i metadati obbligatori, una sorta di impronta digitale invisibile che accompagna il file ovunque vada, garantendo che la sua origine resti identificabile anche dopo modifiche o condivisioni.

Il “10%” come nuovo linguaggio globale

Quel numero, apparentemente tecnico, ha un valore politico. Stabilire una soglia precisa significa passare da un linguaggio vago — “etichette chiare” — a uno misurabile. Il 10% diventa una specie di codice visivo universale: un confine netto tra trasparenza e inganno. È anche un modo per evitare dispute interpretative tra piattaforme e autorità, introducendo una metrica che può essere testata, controllata e verificata.

Questa scelta manda un segnale chiaro alle Big Tech: non è più tempo di autoregolamentazioni flessibili o di linee guida volontarie. L’India, con una semplicità quasi disarmante, sta dicendo che la visibilità della verità può essere calcolata, non solo dichiarata. È un gesto di realismo politico, ma anche di maturità tecnologica.

Dall’autoregolazione alla responsabilità progettuale

Le grandi piattaforme — OpenAI, Meta, X e Google — dovranno modificare i propri sistemi per rendere automatico il processo di etichettatura. Non sarà più sufficiente aggiungere un avviso a valle: il riconoscimento e la marcatura del contenuto dovranno avvenire già nel momento della creazione.

Questo sposta l’onere della responsabilità: non più solo sull’utente o sulla comunità di moderatori, ma sull’architettura stessa del prodotto. È un cambio di paradigma profondo, perché costringe le aziende a pensare la trasparenza come parte integrante del design. Allo stesso tempo, apre una questione economica: chi pagherà il costo dell’implementazione? Per le grandi piattaforme globali il problema sarà gestibile, ma per le startup e i creator indipendenti potrebbe rappresentare una barriera d’ingresso.

Elezioni e spazio civico: la vera posta in gioco

Dietro la spinta regolatoria c’è anche la paura — concreta — che la disinformazione possa manipolare le elezioni. In un Paese dove un video condiviso in un gruppo WhatsApp può raggiungere centinaia di migliaia di persone in poche ore, la capacità di un deepfake di alterare un clima politico è reale.

Etichettare e rendere tracciabili i contenuti è, in questo senso, un tentativo di proteggere la democrazia da una nuova forma di manipolazione, silenziosa e iper-realistica. Tuttavia, nessuna legge può bastare da sola. Senza alfabetizzazione digitale, senza un’educazione alla verifica e al dubbio, anche il sistema più avanzato rischia di diventare un placebo tecnologico. La sfida indiana è culturale prima ancora che normativa.

Bollywood come laboratorio giudiziario

Non è un caso che siano le celebrità di Bollywood a testare i confini del diritto digitale. Le cause legali di Abhishek Bachchan e Aishwarya Rai contro i deepfake che ne sfruttano l’immagine hanno catalizzato l’attenzione pubblica. Questi casi funzionano da laboratorio: mostrano quanto sia difficile proteggere la propria identità in un’epoca in cui l’immagine può essere clonata, remixata e rilanciata in un istante.

L’introduzione di etichette e metadati obbligatori potrebbe facilitare il lavoro dei tribunali, offrendo strumenti concreti per distinguere un contenuto autentico da una falsificazione. Ma la questione va oltre la giurisprudenza: è un tema di cultura digitale, di rispetto e di ridefinizione del concetto stesso di “autorialità”.

L’India tra Europa e Cina: un terzo modello

Sul fronte regolatorio, l’India si muove in una zona intermedia tra il rigore della Cina e l’approccio “etico, ma flessibile” dell’Unione Europea. Pechino ha già imposto l’obbligo di etichettare i contenuti sintetici, ma lo fa con un controllo statale diretto. Bruxelles punta, invece, su responsabilità e valutazione del rischio.

Nuova Delhi tenta una terza via: un modello pragmatico e verificabile, centrato su standard quantitativi. È un compromesso che rispecchia la natura stessa dell’India: un Paese giovane, iperconnesso e caotico, che cerca di domare la tecnologia senza soffocarla. La sua forza è nella chiarezza delle regole; la sua sfida, nella capacità di applicarle in modo coerente in un contesto così vasto.

Economia della trasparenza

Dietro il dibattito normativo si nasconde una questione economica di prima grandezza. L’India è già il secondo mercato al mondo per OpenAI per numero di utenti e la crescita del settore IA è esplosiva. Regolare non significa frenare, ma costruire un ecosistema sostenibile dove l’innovazione non si traduca in abuso.

Le aziende che adotteranno per prime sistemi trasparenti potrebbero addirittura trasformare la conformità in vantaggio competitivo. La “firma digitale” su un contenuto IA può diventare un segno di affidabilità, non di sospetto. È la nascita di un nuovo valore reputazionale, dove l’onestà del processo pesa quanto la creatività del risultato.

Un banco di prova globale

La consultazione pubblica aperta fino al 6 novembre rappresenta la fase più delicata. Qui si decide se la legge diventerà un modello da esportare o un tentativo maldestro destinato a implodere nella burocrazia. Le linee guida dovranno essere chiare, semplici e tecnicamente implementabili. E soprattutto dovranno prevedere eccezioni ragionevoli per la ricerca, la satira, l’arte e la sperimentazione creativa.

Se l’India riuscirà a bilanciare precisione e flessibilità, potrà proporre al mondo una formula replicabile: trasparenza come standard, non come optional.

Addestrare la verità

L’intelligenza artificiale non è un oracolo, è uno specchio. E come ogni specchio, riflette quello che le società scelgono di mostrarsi. L’India, nel chiedere all’IA di “firmare” ciò che crea, non sta solo regolando una tecnologia: sta tentando di riaffermare un principio culturale, quello della responsabilità nella parola e nell’immagine.

La posta in gioco non è la libertà dell’IA, ma la libertà dell’uomo di sapere quando qualcosa è reale. In un mondo dove l’inganno può essere generato con un clic, la trasparenza diventa un atto di civiltà.

La sfida, adesso, è mantenere la promessa: non addestrare solo le macchine a creare meglio, ma addestrare noi stessi a riconoscere il vero. Se l’India riuscirà in questo, non avrà solo scritto una legge: avrà disegnato la mappa etica del nostro futuro digitale.