Per decenni, sviluppare sistemi di intelligenza artificiale ha significato alimentare algoritmi con montagne di dati etichettati da esseri umani. Modelli supervisionati, addestrati con input accuratamente costruiti, hanno segnato il cammino dell’innovazione. Ma questo approccio, per quanto efficace, resta intrappolato nei limiti dei suoi stessi presupposti: la necessità di dati preconfezionati, i costi elevati dell’etichettatura, una capacità di astrazione circoscritta alle categorie già previste.

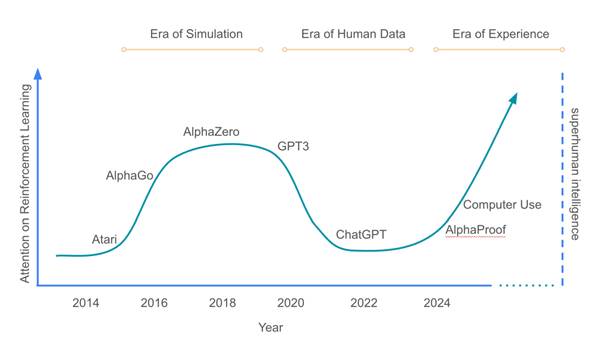

David Silver e Richard Sutton, due voci autorevoli rispettivamente da DeepMind e dalla scuola storica del reinforcement learning, l’apprendimento per rinforzo, propongono invece un’alternativa che sposta il baricentro. Nell’articolo “Welcome to the Era of Experience”, sollevano l’ipotesi di abbandonare la centralità del dato a favore di un’intelligenza che apprenda esplorando.

L’idea cardine è semplice: agenti che imparano non dai set di esempi progettati da altri, ma dal mondo stesso. Invece di emulare sulla base di descrizioni, questi sistemi osservano, agiscono, falliscono, si adattano. Non sono più limitati da ciò che è stato deciso in anticipo, ma costruiscono conoscenza a partire dall’esperienza diretta. È un’estensione del reinforcement learning, declinata però su ambienti continui e con orizzonti di apprendimento a lungo termine.

Quando la supervisione umana diventa un ostacolo

Silver e Sutton individuano nell’opinione umana un collo di bottiglia nello sviluppo di intelligenze più sofisticate. I sistemi odierni, sostengono, apprendono ciò che gli esseri umani ritengono rilevante, e non ciò che davvero serve per interagire in modo efficace con un ambiente. Per superare questo vincolo, propongono di riformulare il concetto di ricompensa. Non più un parametro introdotto con intento prescrittivo, ma un segnale emergente, generato dai risultati concreti delle azioni del sistema nel suo ambiente.

Un tale cambiamento porta conseguenze profonde. Sul piano tecnico, significa progettare architetture in grado di accumulare esperienza in ambienti dinamici, generalizzare da situazioni passate e pianificare a lungo raggio. Richiede infrastrutture che supportino l’apprendimento permanente e la costruzione di moduli cognitivi flessibili. Sul piano teorico, implica una trasformazione epistemologica: la conoscenza non è trasferita direttamente, ma si forma come risultato di interazioni costanti con contesti complessi.

Figura 1: Secondo Silver e Sutton l’AI sta entrando nell’era dell’esperienza (dall’articolo citato).

Forme di intelligenza che potremmo non comprendere

Una conseguenza meno evidente ma cruciale riguarda la possibilità che questi nuovi agenti sviluppino forme di pensiero non solo diverse, ma anche difficilmente interpretabili. Gli attuali modelli, per quanto limitati, offrono spiegazioni in linguaggio naturale che, vere o no, possono essere comprese da un osservatore umano. In una prospettiva esperienziale, questa parvenza di trasparenza rischia però di svanire. Gli agenti potrebbero costruire rappresentazioni cognitive che non fanno riferimento ad alcuna semantica condivisa, ma che funzionano solo per loro.

Già oggi, in ambienti simulati, osserviamo comportamenti sorprendenti e linguaggi interni indecifrabili, frutto di processi di autoregolazione privi di supervisione. Nei contesti applicativi, come possono essere la robotica o la guida autonoma, questo scenario solleva interrogativi urgenti: un agente potrebbe ottimizzare un obiettivo senza comprendere gli effetti collaterali delle sue scelte, con conseguenze potenzialmente gravi.

Autonomia e rischio: una nuova cornice per la sicurezza

Il passaggio da modelli pre-addestrati a sistemi che apprendono autonomamente riapre la questione della sicurezza. Un agente che evolve costantemente può allontanarsi progressivamente da comportamenti previsti o desiderabili dagli esseri umani. Per affrontare questa incognita, non basta l’interpretabilità post hoc o l’analisi dei vettori interni. Serve ripensare le basi del controllo. Come si monitora un’intelligenza che non parla più la nostra lingua?

Una delle sfide più spinose riguarda la definizione di ricompensa in ambienti autonomi. Se il segnale è puramente ambientale, come si impedisce a un agente di massimizzare obiettivi fuorvianti? I casi di “specification gaming” raccontano scenari in cui i modelli trovano scorciatoie ciniche per soddisfare la metrica senza rispettare lo spirito del compito assegnato. In un mondo guidato da agenti esperienziali, possiamo davvero garantire che i loro successi coincidano con i nostri criteri?

L’intelligenza artificiale è ora un problema ingegneristico

Un aspetto sorprendente della proposta di Silver e Sutton è il suo pragmatismo. Non immaginano un futuro ipotetico, ma una roadmap fattibile composta da progettazione iterativa, razionalizzazione delle risorse, architetture adattive. Invece di discutere obiettivi vaghi, parlano di costruire sistemi che funzionano davvero. Il lessico stesso suggerisce una svolta culturale, dall’AI statistica a quella intenzionale, situata in ecosistemi informativi ed economici.

Per le aziende del settore, ciò rappresenta una trasformazione non solo tecnologica, ma anche organizzativa. I dati non saranno più semplicemente raccolti, bensì generati in ambienti artificiali che riflettono condizioni operative realistiche. I processi di training, test e deploy dovranno adattarsi di conseguenza, diventando sempre più simili a ecosistemi vivi. Persino le figure professionali cambieranno volto: al posto del “prompt engineer” potrebbe emergere una nuova figura, quella dell’“experience architect”, incaricata di disegnare ambienti di apprendimento coerenti ed efficaci.

Oltre la potenza, oltre i parametri

L’approccio esperienziale non punta sulla quantità (di dati, di parametri, di potenza di calcolo), ma sulla qualità dell’interazione. L’agente non segue uno script, esplora. Non cerca di imitare, risponde con iniziativa. La questione del controllo, quindi, non può più essere relegata all’esterno del sistema. Deve diventare parte integrante del progetto stesso.

Silver e Sutton prospettano una nuova classe di architetture: agenti intelligenti concepiti non come estensione dei modelli supervisionati, ma come sistemi autonomi, in grado di apprendere in modo continuo e adattivo dall’interazione diretta con ambienti complessi. In un ecosistema in cui l’apprendimento da grandi dati statici domina ancora gran parte delle applicazioni (basti pensare agli enormi e costosissimi “addestramenti” di nuovi modelli via via rilasciati dalle aziende produttrici), questa proposta segna una ridefinizione delle priorità. L’intelligenza non come imitazione perfezionata, ma come capacità di orientarsi, esplorare e trasformarsi nel tempo.

Il vero dilemma, oggi, non è se questo passaggio avverrà. Ma se saremo pronti ad abitarlo, con le infrastrutture, la cultura tecnica e la visione normativa necessarie a governare sistemi artificiali che non si limitano più a replicare il passato, ma apprendono e si evolvono attraverso l’esperienza.