Il 28 aprile 2025 si è verificato un grave blackout elettrico che ha interessato praticamente tutta la penisola iberica.

Il gestore Red Eléctrica de España (REE) ha descritto l’evento come “eccezionale e straordinario”, con un calo improvviso del 60% dell’offerta elettrica nazionale in pochi secondi, dovuto al distacco di due generatori sincroni. Un calo di offerta crea un deficit di potenza attiva con conseguente caduta di frequenza.

Blackout iberico: un evento “eccezionale e straordinario” ma non del tutto imprevedibile

Secondo le fonti tecniche spagnole, la frequenza di rete è scesa repentinamente rispetto al valore standard (50 Hz in tutta Europa), innescando il distacco automatico delle centrali per proteggere le infrastrutture.

Questi sembrano essere i fatti, come riassunti dal responsabile delle operazioni della rete spagnola che ha menzionato due eventi molto ravvicinati, probabilmente disconnessioni dovute a malfunzionamenti di impianti fotovoltaici in Estremadura, regione del sud-ovest della Spagna (le cause effettive, però, non sono state rivelate):

- primo evento: alle 12:33, un calo di 15 GW (60% della produzione nazionale);

- secondo evento: 1,5 secondi dopo, un ulteriore calo che ha reso il sistema instabile.

Alla prima disconnessione la rete avrebbe retto, ma non al secondo evento, anche perché subito la rete francese si è disconnessa per ragioni di protezione, rendendo la rete elettrica della penisola iberica un sistema isolato (se si eccettua il cavo con il Marocco che porta poca potenza).

La frequenza sembra sia crollata da 50 Hz a 47,8 Hz in 2 secondi, superando le soglie di protezione.

Il calo repentino avrebbe causato un vero e proprio effetto domino (ad ogni disconnessione seguiva una riduzione di frequenza che causava altre disconnessioni e così via) e quindi il collasso dell’intera rete.

Solo quattro giorni prima, il 24 aprile 2025, REE aveva annunciato che la Spagna aveva raggiunto il 100% di energia rinnovabile, con circa il 75% proveniente da fonti di energia solare. Al momento del blackout, il 28 aprile, il mix energetico includeva il 60% di solare, il 12% di eolico e una quota residuale di nucleare e gas.

Il governo spagnolo non ha ritenuto di potere, al momento, escludere alcuna delle possibili cause all’origine dello sfortunato fenomeno. Tuttavia il primo ministro Sánchez ha escluso esplicitamente un legame diretto con le rinnovabili:

“Non c’è stato alcun problema di eccesso di energia rinnovabile, né di mancanza di copertura o di domanda insoddisfatta. Chi collega questo incidente alla mancanza di energia nucleare sta mentendo o dimostrando ignoranza”.

È evidente che, in mancanza di dati e informazioni di prima mano, si può solo fare qualche valutazione generale, senza alcuna pretesa di spiegare l’evento spagnolo in sé, che richiederà qualche mese di analisi dei dati di rete. Tuttavia l’affermazione del premier spagnolo, a prima vista, sembra solo parzialmente sostenibile (oltre a contraddire l’intento di non escludere a priori nessuna possibilità), e sembra presentare alcune criticità concettuali che vorrei esaminare tecnicamente.

Pertanto, lungi dal partecipare al dibattito in corso se le rinnovabili siano state o no la causa diretta dell’evento, vorrei chiarire perché l’elevatissima penetrazione di generazione solare/eolica può esacerbare la fragilità di un sistema elettrico nazionale. Al proposito scrive Reuters: “Al momento dell’interruzione la rete spagnola funzionava con pochissima «inerzia», ovvero l’energia che si muove in una grande massa rotante come un generatore o in alcuni motori industriali. L’inerzia aiuta a stabilizzare la rete rallentando la velocità di variazione della frequenza quando si verifica un improvviso calo o aumento della domanda o della produzione. In queste condizioni (quando c’è poca inerzia) – prosegue Reuters – se c’è un calo di produzione per qualsiasi motivo, la rete perde (più) inerzia e tutto si guasta.”

In queste reti i meccanismi di stabilizzazione non possono essere equivalenti a quelli di una rete tradizionale ed entrano in gioco inerzia e latenza di intervento. Il concetto da tenere presente è che un sistema distribuito a bassa inerzia e in presenza di latenza è poco robusto (“fragile”), ossia ha dominio di stabilità più limitato e da ciò deriva il maggior rischio di collasso. Se una rete è fragile lo è per scelta progettuale e, quindi, un blackout rimane un evento “eccezionale e straordinario”, ma non può dirsi del tutto imprevedibile.

Gli effetti di inerzia e latenza in una rete elettrica

Il livello di fragilità di una rete si lega all’inerzia e alle latenze di misura e calcolo. L’inerzia è di due tipi: fisica o sintetica. L’inerzia fisica è una proprietà passiva e distribuita (ogni generatore contribuisce autonomamente), non richiede comunicazione tra nodi. È lì, presente, potremmo dire “immanente” (ce la dà Madre Natura). L’inerzia sintetica, l’unica di cui possono essere dotati gli impianti solari/eolici, non è equivalente a quella fisica, perché richiede elaborazioni e quindi introduce latenza.

L’inerzia fisica è energia cinetica immagazzinata nelle masse rotanti (es. turbine, alternatori), che reagisce istantaneamente ai cambiamenti di frequenza. L’inerzia sintetica invece dipende da sensori e controlli elettronici, quindi c’è una latenza di molte decine di millisecondi e a volte centinaia (latenze di misura e calcolo). Inoltre, l’inerzia fisica ha una risposta passiva, mentre quella sintetica è attiva e richiede energia dagli accumulatori, che hanno limiti di capacità.

Ma perché l’inerzia fisica è “istantanea”? Nulla è davvero istantaneo, evidentemente, ma l’inerzia fisica è quanto di meglio gli si possa avvicinare: fornisce una risposta autonoma e immediata di riequilibrio che inizia ad agire dopo un tempuscolo trascurabile. Quando si verifica un deficit di generazione, dovuto ad es. a un distacco, la riduzione di frequenza induce un flusso istantaneo di energia cinetica dalle masse rotanti alla rete, proporzionale alla rapidità del calo di frequenza o Rate of Change of Frequency (RoCoF) = df/dt . Questo fenomeno fisico, regolato dalle leggi della meccanica newtoniana, equivale a un’intrinseca retroazione negativa in frequenza che contrasta lo squilibrio, senza necessità di interventi elettronici o algoritmi di controllo.

L’inerzia fisica, legata all’energia cinetica delle masse rotanti, è sempre attiva e in caso di guasti rallenta la velocità di caduta della frequenza, RoCoF, rispetto a un sistema privo di inerzia. Per questo motivo il tempo di risposta è quasi nullo, perché la compensazione della frequenza è una proprietà intrinseca delle masse rotanti sincrone (1). Questo effetto di freno naturale fa guadagnare tempo prezioso affinché i sistemi di controllo attivi (come gli inverter grid-forming o i governor delle centrali) possano intervenire, aumentando la generazione di potenza o riducendo i consumi per riequilibrare domanda e offerta in rete.

In reti prive di inerzia fisica, l’inerzia può solo essere emulata con circuiti elettronici, gli inverter grid-forming: tuttavia secondo alcune fonti, sembrerebbe che in Spagna generalmente gli inverter siano privi di questa funzionalità e che siano adottati i più antiquati inverter grid-following che in situazioni di crisi staccano il generatore associato; questo peggiora la criticità che però non scompare del tutto neppure con i sistemi più moderni.

Evidentemente i blackout avvengono comunque, in qualsiasi tipo di rete, ma in presenza di componenti “fisiche” la probabilità è ridotta e così anche il rischio. Infatti, non basta neppure l’inerzia fisica se lo squilibrio è troppo grande rispetto alla quantità di energia cinetica disponibile; se i controlli attivi sono lenti, mal configurati o insufficienti; se troppi guasti in cascata superano la capacità di risposta del sistema.

In sintesi, l’inerzia fisica è un meccanismo di primo intervento che mitiga la portata dell’emergenza, proprio come l’ambulanza che porta il defibrillatore; l’inerzia sintetica, che si attiva dopo, è un aiuto tecnologico, utile ma non con identiche proprietà: oggi servono entrambe, insieme a controlli rapidi e ridondanza, per evitare o ridurre fortemente i collassi.

L’inerzia sintetica, infatti, richiede una serie di azioni in cascata:

- Rilevamento della frequenza con sensori che misurano il RoCoF con una latenza di 10-30 ms

che dipende dalla tecnologia.

- Elaborazione del segnale con algoritmi di controllo che calcolano la potenza necessaria, intro-

ducendo un ritardo di 5-20 ms.

- Attuazione con gli inverter che modificano la potenza erogata, con un ritardo di 1-10 ms che

dipende dal tipo di convertitore

Si ha una latenza totale fino a circa 50-60 ms (poi, l’effetto del ritardo sulla probabilità è esponenziale): certo, la tecnologia mano a mano migliora ma è lecito dubitare che mai potrà essere equivalente al caso “fisico”.

Nel caso del blackout iberico si può ipotizzare (salvo naturalmente attendere le analisi approfondite, quando saranno rese disponibili) che, per effetto di due distacchi ravvicinati di impianti solari in una rete ormai praticamente tutta riconvertita alle fonti solare/eolico, la mancanza o insufficienza di inerzia fisica o l’inerzia sintetica (fornita da inverter e batterie), se presente, potrebbe non essere riuscita a compensare il calo di frequenza a causa di ritardi nella risposta degli accumulatori e mancanza di coordinamento tra inverter distribuiti.

La lezione che si ricava a mio parere è questa: con l’avvento di reti nazionali interamente solari/eoliche si riduce inevitabilmente il dominio di stabilità del sistema. Sapere di quanto aumenta il rischio, tuttavia, richiederebbe indagini approfondite che esulano dall’intento di questo articolo e dagli strumenti del suo autore.

Il punto importante da rimarcare è che la rete solo solare/eolica è distribuita e affetta da latenza, e opera in assenza di inerzia fisica adatta a rallentare efficacemente il RoCoF: questa è una differenza sostanziale, di principio prima ancora che pratica, fra una rete tradizionale, o mista, e una rete con il 100 % di fonti rinnovabili solari/eoliche (non idriche, termiche o nucleari).

Le reti distribuite in cui sono presenti latenze di comunicazione fra i nodi sono da decenni patrimonio conoscitivo degli operatori delle telecomunicazioni. Il primo evento a cui sono stati costretti a fare fronte è stata la congestione della rete ARPANET (oggi Internet) del 1971 che ha portato ad introdurre il protocollo di controllo di flusso TCP per evitare il ripetersi di eventi distruttivi del servizio in una rete distribuita. Il fenomeno fu causato da un carico di traffico eccessivo, che svelò una lacuna critica nel design iniziale dei protocolli e delle strategie di gestione della rete a pacchetti. Alla base c’era comunque un sistema distribuito, come nel caso del grid elettrico (anche se i due tipi di blackout non vanno confusi in quanto le fenomenologie sono diverse). Oggi, tuttavia, un “TCP elettrico” non esiste e pertanto le reti prive di inerzia fisica presentano fragilità: inoltre la fisicità della rete elettrica presenta difficoltà superiori per cui, probabilmente, un apposito protocollo non basterebbe comunque.

Un’altra analogia, che perde la caratteristica della rete distribuita ma è più pertinente nel combinare gli aspetti elettrici e quelli meccanici, potrebbe essere quella dell’incidente d’auto in cui il sistema di primo intervento è l’airbag che si attiva subito, assorbendo l’urto iniziale (come l’inerzia meccanica delle turbine che rilasciano energia cinetica, riducendo il RoCoF, ad es. da -2 Hz/s a -0,5 Hz/s). Segue l’automatismo di frenatura dell’ABS che interviene dopo per evitare ulteriori danni (come la risposta primaria delle turbine che aumentano la potenza erogata, ad es. di +500 MW, tramite regolazione meccanica). Infine interviene il cambio di direzione del sistema di guida autonoma che sterza prima dell’impatto, ma ha bisogno di tempo per elaborare i dati (come le batterie e il grid-forming).

Naturalmente, è tutto da verificare con i dati, ma problemi combinati di inerzia e latenza in una rete distribuita potrebbe essere quanto meno una delle ragioni per cui gli ingegneri elettrici spagnoli

sono caduti in questa brutta disavventura.

Riflessione su un case-study

Potrebbe essere utile esaminare due scenari alternativi con lo spirito del case-study, in una prospettiva al 2030.

Facciamo il caso, puramente teorico, di un gestore elettrico infrastrutturale che ha il 50% di energia alternativa solare e eolica già installata (con poco o nullo contributo idroelettrico o geotermico) e si trovi a decidere lungo due diversi percorsi di sviluppo strategici per mirare alla piena decarbonizzazione:

A) sostituire il rimanente 50% di fonti tradizionali con altrettante fonti alternative solare/eolico;

B) sostituire il rimanente 50% con fonti nucleari SMR (small modular reactor) dotate di turbina

(un generatore nucleare genera calore e può essere seguito da una turbina). (2)

Quali vantaggi e svantaggi si possono intravedere per le due alternative?

I principali vantaggi tecnici dell’Opzione A (100% solare e eolico) sono: (a) nessuna emissione diretta (completa decarbonizzazione); (b) modularità con distribuzione geografica che riduce i rischi di guasti concentrati; (c) scalabilità che consente l’aggiunta di nuovi impianti senza vincoli termodinamici. D’altra parte si hanno anche svantaggi tecnici: (a) assenza di inerzia fisica e maggiore rischio di superamento delle soglie di frequenza critiche; (b) dipendenze critiche da intermittenza, da cui la necessità di capacità sovradimensionata di storage; (c) necessità di grid-forming inverter con requisiti di sincronizzazione e coordinamento complessi e necessità di capacità predittive con uso di IA; (d) micro-variazioni per l’assenza di grandi generatori sincroni che aumenta la sensibilità ai disturbi locali.

D’altra parte l’Opzione B (50% SMR dotati di turbina) ha i vantaggi tecnici di: (a) inerzia fisica in quanto le turbine degli SMR forniscono inerzia rotazionale equivalente a quella tradizionale (H ≈ 3−5 s); (b) minore dipendenza da accumulatori per la regolazione di frequenza; (c) complementarità con rinnovabili in quanto gli SMR forniscono carico di base costante, bilanciando l’intermittenza di solare/eolico. Anche in questo caso si hanno svantaggi tecnici: (a) minore flessibilità, con tempi di avvio/arresto più lunghi rispetto a gas/batterie (minore adattabilità a picchi di domanda); (b) complessità di integrazione per la necessità di mantenere un minimo carico termico anche in presenza disurplus di produzione da fonti solare/eolico.

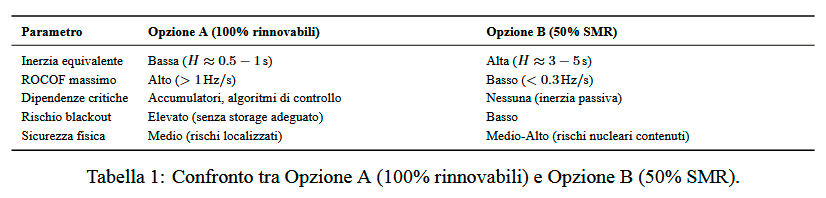

La Tabella 1 riassume i vantaggi e gli svantaggi tecnici delle due opzioni a confronto.

In estrema sintesi, l’Opzione B offre un margine di stabilità significativamente superiore, riducendo i rischi di collasso sistemico. L’Opzione A richiederebbe innovazioni radicali in controlli e storage per essere sicura.

Conclusioni

Le cause del blackout iberico non sono tuttora accertate, ma la bassa inerzia passiva del sistema può avere amplificato la vulnerabilità alla propagazione del guasto. Un sistema privo di inerzia rotazionale è intrinsecamente fragile, poiché l’inerzia sintetica, pur mitigando il RoCoF, non elimina i rischi legati alla latenza di intervento (10-50 ms) e alla dipendenza da riserve di storage.

Il rafforzamento tramite interconnessioni internazionali è limitato dalla propensione delle reti confinanti a disconnettersi sotto stress, rendendo essenziale la resilienza autonoma di ogni rete nazionale.

Un esame comparativo tecnico tra un’opzione 100% rinnovabile solare/eolico (A) e una con integrazione di SMR (B) evidenzia che:

- l’Opzione B è superiore in termini di stabilità per reti continentali, grazie all’inerzia fisica e alla

prevedibilità degli SMR, sebbene la tecnologia sia ancora in fase di sviluppo;

- l’Opzione A sembra consigliabile solo in contesti geograficamente limitati (isole, microgrid)

con storage sovradimensionato (es., ≥12 ore di autonomia) e algoritmi di controllo predittivo

(es., IA per bilanciamento carico/generazione).

La soluzione ottimale per reti continentali ad alta decarbonizzazione rimane un mix ibrido, che combini l’inerzia fisica di una quota di generatori sincroni con la flessibilità di rinnovabili e storage. Se si intende accelerare la migrazione verso un sistema elettrico ad altissima decarbonizzazione sarebbe opportuno accelerare le attività volte all’introduzione della tecnologia SMR.

Note:

(1) A questo proposito si rinvia a pag. 8 del rif. [1] ove si legge “The initial value of the df/dt is the instantaneous RoCoF just after an imbalance of power in the electrical power system (i.e. disconnection of a generator/load tripping), before the action of any control.” Si osservi l’inversa proporzionalità con il fattore di inerzia, H [s], e nessuna dipendenza dalla variabile temporale, da cui l’azione istantanea del sistema passivo. Questo principio è la base per comprendere perché le reti con alta penetrazione di solare/eolico (basso H) sono più vulnerabili ai blackout, nonostante l’uso di controlli attivi avanzati; a questo va aggiunta la latenza di intervento. È la sinergia tra i due fattori, basso H e latenza, alla base del

rischio sistemico del sistema dotato di sole rinnovabili solari/eoliche. Nel caso dell’eolico si noti che ciò avviene perché la velocità delle pale non è vincolata alla frequenza di rete (asincrona), a differenza dei generatori sincroni tradizionali.

(2) Questi oggi sono operativi in due soli casi, in Russia e in Cina, e per il resto sono a diverse fasi di sviluppo: è per questo motivo che il confronto lo riferisco a una prospettiva ipotetica al 2030.

Riferimenti

[1] ENTSOE, “Inertia and Rate of Change of Frequency (RoCoF),” Version 17 SPD – Inertia TF, 16. Dec. 2020