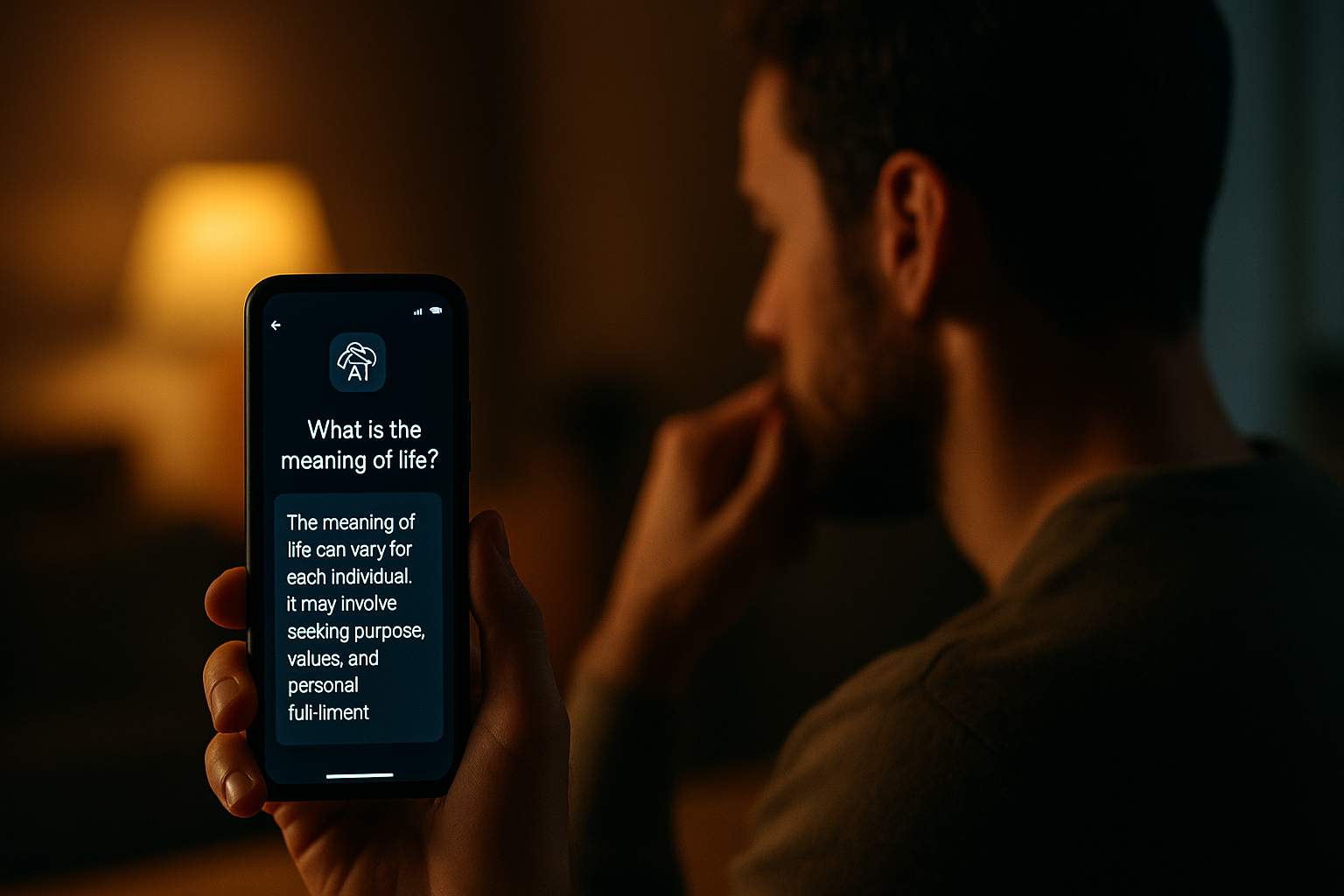

In una notte insonne, un uomo scorre lo schermo del telefono e apre un’app di Intelligenza Artificiale. Non cerca notizie né intrattenimento: desidera una risposta. Scrive una domanda esistenziale, forse ingenua, forse urgente.

Attende…

La replica arriva in pochi secondi: composta, fluida, rassicurante. Nessuna voce ha parlato, nessun volto si è mostrato, ma lui sente di aver ricevuto un consiglio. Lo prende sul serio. In un’altra epoca avrebbe forse cercato un sacerdote, un maestro, un oracolo. Oggi interroga un modello linguistico e non si stupisce. Non chiede chi abbia generato quella risposta, né da quali logiche sia emersa.

Il tempio si è smaterializzato: non c’è incenso, né sacralità, ma solo un’interfaccia grafica, un algoritmo, un server remoto. Tuttavia, il gesto rimane lo stesso: affidare all’ignoto il compito di orientare il proprio destino. Questa dinamica – apparentemente inedita – ha radici storiche profonde. Lo dimostra il lungo processo che ha condotto dalla geometria del caso alle architetture statistiche moderne, passando per le pratiche sociali e morali del gioco, dell’assicurazione e della rendita.

Già nel XVIII secolo, le lotterie e le rendite viagère rappresentavano forme codificate di gestione dell’incertezza: strumenti per proiettare nel futuro le aspettative individuali e collettive, incapsulando il rischio in formule e contratti. Michel Armatte ha descritto con acutezza il passaggio che condusse dalla condanna religiosa del gioco d’azzardo alla sua progressiva istituzionalizzazione da parte degli Stati monarchici, che trasformarono le lotterie in dispositivi di governo, finanziamento e consenso. Nella Francia prerivoluzionaria, il castelletto era l’organo segreto della lotteria di Stato, incaricato di calcolare gli equilibri tra vincite e perdite per garantire l’utile del sovrano, mentre l’estrazione appariva pubblica e trasparente. Dietro l’apparente casualità si celava un sapere tecnico, discreto, potentemente selettivo.

Oggi il castelletto ha cambiato forma, ma non funzione. Gli LLM – i modelli linguistici di grandi dimensioni – agiscono secondo logiche probabilistiche sofisticate, fondate sull’analisi statistica di

immense quantità di dati. Anch’essi producono risposte che appaiono naturali, ma sono in realtà esiti di una selezione algoritmica profonda, modellata da architetture computazionali e dai dati che le nutrono. In continuità con la tradizione che da John Graunt e Halley conduce fino a Deparcieux e Condorcet, l’Intelligenza Artificiale moderna eredita il compito di ridurre l’incertezza attraverso la quantificazione. Ma a differenza dei predecessori, il modello contemporaneo cancella l’ambiguità non solo come errore, ma come disfunzione epistemologica. Laddove l’oracolo parlava in modo enigmatico e richiedeva interpretazione, l’algoritmo restituisce suggerimenti strutturati, percentuali, sintesi immediatamente fruibili.

Questa dinamica si manifesta con particolare evidenza in settori strategici come l’istruzione, la sanità e la giustizia. Nei sistemi assicurativi, ad esempio, gli algoritmi vengono ormai utilizzati per anticipare il rischio individuale sulla base di dati aggregati, riducendo la complessità biografica a un punteggio predittivo. Nell’istruzione, i modelli AI assistono la valutazione e la personalizzazione dei percorsi didattici, ma allo stesso tempo definiscono implicitamente una norma comportamentale e cognitiva. In ambito giudiziario, assistiamo alla sperimentazione di software predittivi in grado di suggerire pene o probabilità di recidiva, con il rischio di cristallizzare pregiudizi statistici sotto l’apparenza di imparzialità computazionale. In tutti questi casi, la semplificazione operata dalla

macchina maschera un’economia della decisione che premia l’efficienza ma comprime la libertà.

Per comprendere appieno questa trasformazione, occorre però operare un passaggio analitico: dalla genealogia storica delle pratiche predittive alla critica della struttura contemporanea che le incarna. Se nel passato i dispositivi statistici erano finalizzati al governo di popolazioni e territori, oggi i modelli linguistici generativi agiscono come infrastrutture epistemiche globali. La loro potenza non risiede solo nella capacità di rispondere, ma nella funzione di assorbire, ricombinare e monetizzare la conoscenza prodotta dagli utenti. Gli LLM diventano così parte integrante di un capitalismo estrattivo cognitivo, in cui il sapere è raccolto, raffinato e restituito in forma predittiva. L’output, apparentemente gratuito, è in realtà il frutto di un’economia dell’attenzione e del comportamento, in cui l’infrastruttura tecnica si confonde con il potere simbolico.

Lorraine Daston ha dimostrato come la nascita dell’assicurazione non dipese dal calcolo delle probabilità, ma da un tessuto sociale fondato sulla fiducia e sull’equità. Solo più tardi la matematica giustificò retrospettivamente pratiche già in uso, attribuendo loro una razionalità ex post. In modo analogo, l’AI oggi si presenta come uno strumento oggettivo di analisi e supporto alle decisioni, ma spesso non fa altro che ricalcolare il passato, offrendo risposte che rispecchiano le attese mediate dai dati. La funzione predittiva si fonda su una ricorsività statistica, non su una vera apertura al nuovo. Ed è proprio questo che conferisce all’AI il carattere di un “oracolo senza mistero”: un ente non senziente, ma culturalmente autorevole, che appare imparziale proprio in quanto opaco. Non ne conosciamo i parametri di addestramento, le funzioni di perdita, le euristiche di ottimizzazione, e tuttavia ne accettiamo le risposte come se fossero valide in sé, senza chiederci da quale visione del mondo provengano.

Il rischio più profondo non è dunque l’autonomia delle macchine, ma la nostra rinuncia all’interpretazione. La risposta automatica, nella sua apparente neutralità, tende a cancellare il processo che l’ha prodotta. Ogni elemento conflittuale, ogni dimensione contestuale, ogni traccia di intenzionalità viene rimossa. La fascinazione per la forma – pulita, coerente, fluida – prende il posto dell’esercizio critico. Come un tempo il popolo partecipava alla lotteria pubblica credendo di esercitare una possibilità, mentre il castelletto assicurava la rendita alla monarchia, oggi ci illudiamo di esercitare un libero arbitrio informato, mentre seguiamo percorsi suggeriti da sistemi che apprendono dai nostri stessi comportamenti passati.

Nel contesto delle lotterie settecentesche, Talleyrand denunciava l’ingiustizia insita in un gioco che si alimentava della speranza dei più deboli. La lotteria, scriveva, «est et au plus haut degré injuste et immoral», perché raccoglieva consenso attraverso la manipolazione dell’aspettativa. L’analogia con l’Intelligenza Artificiale generativa è netta: anche oggi, il rischio non risiede tanto nella falsità delle risposte, quanto nella loro verosimiglianza, nella loro capacità di farsi accettare come esito naturale. E come nel passato la macchina del gioco serviva a legittimare decisioni economiche e politiche, così oggi la macchina linguistica tende a strutturare i modi in cui il sapere viene prodotto, ordinato, reso rilevante.

Byung-Chul Han ha descritto l’AI come una “intelligenza oracolare” che elimina l’ambiguità. Ma è proprio l’ambiguità, l’irriducibilità del senso, la lentezza della comprensione, a costituire il cuore dell’esperienza umana. Ogni modello predittivo – statistico o neurale – è anche un modello normativo. Decide non solo cosa è probabile, ma cosa vale la pena considerare. Dietro ogni suggerimento c’è un’ontologia implicita, un filtro culturale, un dispositivo di potere.

La posta in gioco, allora, è epistemica. Riguarda il nostro rapporto con la complessità, la nostra disponibilità a tollerare l’incertezza, a rifiutare il conforto dell’immediatezza. Come nel XVIII secolo si passò da un’idea sacrale del destino a una logica assicurativa che cercava di amministrarlo, oggi rischiamo di passare dalla libertà del pensiero alla delega automatica della decisione. Ogni volta che un modello generativo risponde, a parlare non è una coscienza, ma una sequenza statistica ottimizzata. Il fatto che quella risposta “funzioni” non equivale a dire che sia giusta, fondata, desiderabile.

Proprio per questo, è urgente riaffermare la necessità di una resistenza epistemica fondata sulla trasparenza algoritmica, sull’educazione critica e sulla governance partecipativa dell’innovazione.

Se vogliamo evitare che la parola automatica diventi un nuovo dogma, dobbiamo costruire istituzioni capaci di garantire pluralismo cognitivo e accesso al contesto decisionale. In questo senso, la storia delle lotterie, delle assicurazioni e delle statistiche non ci parla solo del passato: ci insegna a riconoscere, nel volto dell’algoritmo, le genealogie invisibili del potere. E a ricordarci che ogni delega al calcolo è anche una scelta politica.

Dalla statistica alle AI generative: una delega spirituale, epistemica e politica alla macchina?

Giovanni Di Trapani

Giovanni Di Trapani