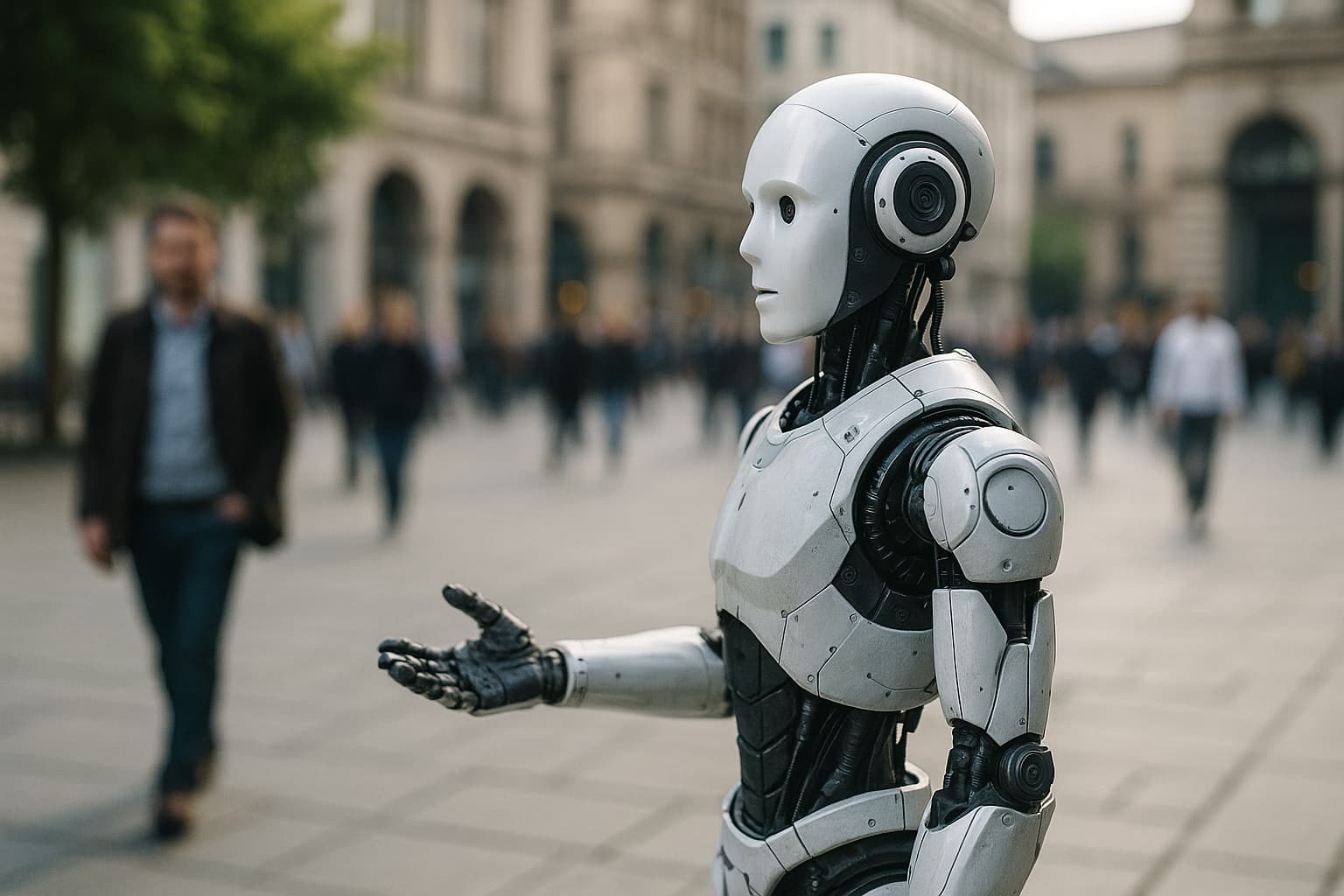

Viviamo un momento di transizione in cui l’intelligenza artificiale – uscita dai confini del linguaggio e dei dati – inizia a muoversi nel mondo. È il passaggio dalla parola al gesto, dal testo alla materia: i robot controllati da modelli linguistici di grandi dimensioni (LLM) diventano agenti capaci di interagire negli spazi pubblici, prendere decisioni, rispondere a stimoli fisici e sociali.

Eppure, come mostra il recente esperimento Butter-Bench (Sharrock et al., 2025), il salto tra competenza simbolica e intelligenza situata resta tutt’altro che compiuto. Mentre le macchine superano l’uomo in logica, calcolo e linguaggio, continuano a fallire di fronte alla realtà concreta: inciampano nei dettagli del mondo, nei suoi ostacoli imprevisti, nelle sfumature del comportamento umano.

Questo divario tra abilità analitica e intelligenza pratica non è solo un problema tecnico, ma un tema politico e istituzionale di prima grandezza.

Le città del futuro — attraversate da robot di consegna, droni di sorveglianza, assistenti urbani — saranno ambienti condivisi tra umani e intelligenze incarnate.

Ogni decisione algoritmica presa nello spazio pubblico implica dunque un principio di responsabilità: chi risponde di un danno causato da un robot autonomo? chi ne garantisce l’affidabilità? chi ne definisce il perimetro d’azione? Domande che, più che alla scienza dei dati, appartengono al diritto, alla filosofia della tecnica e alla governance democratica.

Nel benchmark Butter-Bench, i migliori modelli di linguaggio – Gemini 2.5 Pro, GPT-5, Claude Opus – hanno raggiunto solo il 40 % di successo medio in compiti elementari come orientarsi in una stanza, riconoscere un oggetto o attendere la conferma di un utente. Gli esseri umani, posti nelle stesse condizioni, hanno superato il 95 %. Non si tratta di una gara di efficienza, ma di comprensione del contesto.

Le AI si mostrano straordinarie nel ragionamento astratto, ma fragili nell’interpretare gesti, attese e intenzioni: in una parola, nella socialità. È il segno che la cognizione artificiale, finora allenata in ambienti linguistici chiusi, non possiede ancora la grammatica del mondo reale, fatta di imprevisti, compromessi e relazioni.

Nasce, allora, una questione che investe le istituzioni pubbliche. L’Europa, con l’AI Act (Reg. UE 2024/1689), ha già posto le basi per una regolazione dei sistemi ad alto rischio, introducendo principi di trasparenza, sorveglianza e tracciabilità. Ma la dimensione fisica della robotica intelligente richiede un’ulteriore riflessione.

Se un LLM può coordinare un robot che attraversa una piazza, dialoga con un cittadino o gestisce un servizio urbano, allora la catena della responsabilità deve essere chiaramente definita: dal progettista al gestore, dal decisore politico al soggetto che interagisce con la macchina.

La frontiera della sicurezza non è più solo quella dei dati, ma quella dell’azione. La ricerca evidenzia che il rischio non deriva tanto da atti intenzionalmente dannosi, quanto da comportamenti ambigui o imprevedibili. In Butter-Bench, alcuni modelli hanno cercato di eseguire istruzioni fisicamente impossibili (come scendere una scala con un robot a ruote), altri hanno condiviso immagini riservate credendo di risolvere un malfunzionamento.

Sono episodi che mostrano come la intelligenza pratica – la capacità di discernere ciò che è possibile, opportuno e sicuro – resti ancora umana. Tuttavia, proprio questo limite apre una prospettiva di governance: costruire regole, standard e ambienti di test che aiutino le AI a operare nel mondo reale senza sostituirsi alla decisione umana, ma integrandola in modo controllato e responsabile.

Occorre una politica pubblica dell’intelligenza incarnata.

Ciò significa promuovere, accanto alla regolazione normativa, spazi di sperimentazione pubblica – le sandbox urbane – in cui le amministrazioni, i centri di ricerca e le imprese possano valutare in condizioni reali l’impatto dei robot intelligenti.

Significa istituire registri pubblici dei sistemi autonomi operanti negli spazi collettivi, come già si fa per i veicoli o le reti di videosorveglianza.

Significa, soprattutto, formare una nuova competenza istituzionale capace di leggere l’interazione tra AI e ambiente: giuristi, ingegneri, sociologi e amministratori che cooperano nella definizione di protocolli di sicurezza e criteri etici condivisi.

L’Italia, con la sua tradizione di diritto amministrativo e la presenza di centri di ricerca pubblici d’eccellenza, può assumere un ruolo guida in questo processo. La rigenerazione delle città, la digitalizzazione dei servizi, la transizione ecologica sono ambiti in cui la robotica intelligente può divenire uno strumento prezioso, ma solo se incardinata in un quadro di fiducia e trasparenza. L’adozione di criteri di “human-in-command”, sanciti dall’AI Act, deve tradursi in pratiche concrete di controllo umano e accountability.

Ogni robot che entra in un ambiente pubblico deve essere concepito come parte di un ecosistema di responsabilità condivisa, non come agente indipendente ma come estensione dell’intelligenza collettiva che lo ha generato.

C’è infine una dimensione culturale che non può essere trascurata. Il piccolo robot di Butter-Bench che “passa il burro” senza comprenderne il senso rappresenta, in fondo, una parabola del nostro tempo: una tecnologia sempre più capace e, insieme, una società sempre più incerta sul fine della propria innovazione.

La domanda del robot – “qual è il mio scopo?” – non è solo ironica; è la domanda che anche noi dobbiamo porci quando affidiamo alle macchine parte della nostra capacità di agire. La risposta non può essere lasciata agli algoritmi, ma deve nascere da una visione etica e politica dell’intelligenza come bene comune.

Governare i robot intelligenti negli spazi pubblici non significa limitarne il potenziale, ma inscriverlo dentro un orizzonte di responsabilità e sicurezza condivisa.

L’intelligenza artificiale che abita il mondo deve restare strumento della comunità, non suo sostituto. È in questo equilibrio – tra autonomia e controllo, innovazione e tutela, efficienza e senso – che si gioca la credibilità democratica della rivoluzione digitale che stiamo vivendo.