Negli Stati Uniti è accaduto qualcosa che, al di là della cronaca, merita di essere osservato con attenzione: alcuni studenti di Harvard e MIT hanno scelto di abbandonare il percorso universitario non per fondare una startup, come spesso avviene nei contesti accademici più competitivi, ma per un motivo inedito. La ragione dichiarata è la preoccupazione per l’arrivo imminente di una “super intelligenza artificiale”, quella che in gergo tecnico viene chiamata Artificial General Intelligence (AGI).

Un sondaggio interno ad Harvard ha reso il quadro ancora più significativo: circa la metà degli studenti teme che l’AI possa compromettere il proprio futuro professionale e oltre il 40% considera i rischi connessi a questa tecnologia paragonabili a quelli di una pandemia o di una guerra nucleare.

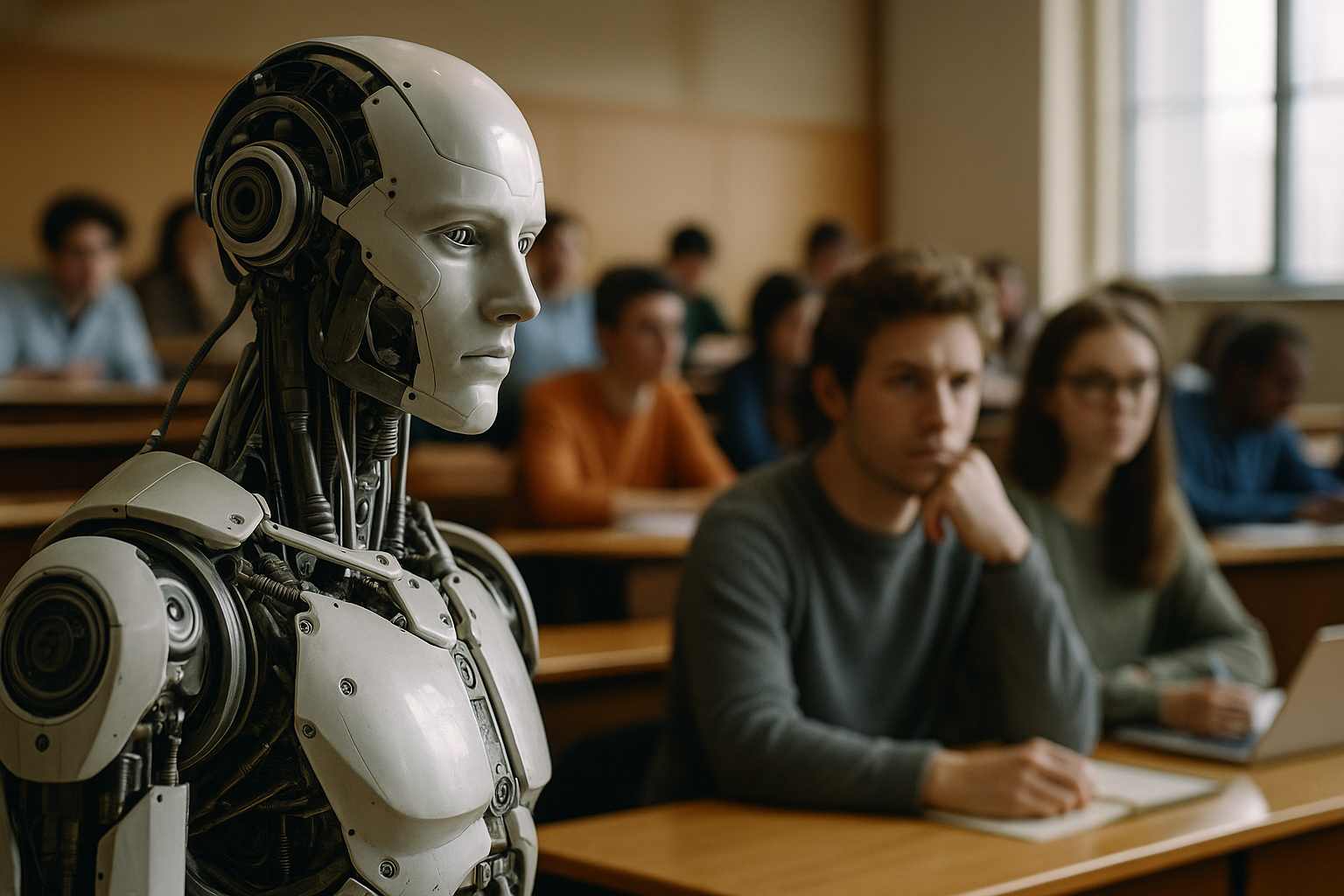

Non è quindi solo una vicenda di ansia individuale. Si tratta piuttosto di una nuova consapevolezza collettiva: l’intelligenza artificiale non viene più percepita come semplice oggetto di studio, ma come sfida esistenziale che potrebbe trasformare in profondità il nostro modo di vivere e lavorare. Questo passaggio da tema accademico a questione pubblica è, in sé, un fenomeno politico e culturale che interroga direttamente l’etica.

Il concetto di AGI evoca la possibilità che una tecnologia sia in grado di superare l’essere umano in quasi tutti i compiti cognitivi. Che si tratti di un obiettivo realistico o di un’ipotesi ancora lontana, è innegabile che la sola idea stia già producendo conseguenze concrete: studenti che rinunciano agli studi per impegnarsi in centri di ricerca dedicati all’AI safety, ricercatori che invocano moratorie sullo sviluppo di modelli avanzati, opinione pubblica polarizzata tra entusiasmo e timore.

La paura, in questo caso, non è semplice panico: è una forma di mobilitazione etica. Non si fugge dal futuro, ma si sceglie di anticiparlo, con la convinzione che occorra intervenire subito per prevenire rischi catastrofici.

Che alcuni giovani talenti decidano di interrompere il percorso universitario rivela un altro aspetto cruciale: la percezione che i tempi lunghi della formazione accademica siano inadeguati a fronteggiare l’urgenza tecnologica. L’università, luogo storicamente deputato alla costruzione critica del sapere, appare in ritardo rispetto al ritmo delle trasformazioni. È un segnale che interpella le istituzioni educative: come rinnovare i modelli di apprendimento affinché non siano soltanto spazi di trasmissione delle competenze, ma anche luoghi capaci di attrezzare culturalmente ed eticamente i cittadini del futuro?

L’ansia degli studenti non va dunque liquidata come sintomo di fragilità, ma letta come domanda di nuove infrastrutture culturali.

Equiparare i rischi dell’AI a quelli di una pandemia o di un conflitto nucleare è un atto che non può lasciare indifferenti. In questa equiparazione c’è il riconoscimento che la tecnologia, una volta oltrepassata una certa soglia di potenza, non è più solo un bene strumentale ma una forza capace di incidere sulla sopravvivenza collettiva. Non è un caso che studiosi come NickBostrom abbiano parlato di existential risks, aprendo il campo a un’etica del futuro che richiama l’umanità intera a un principio di responsabilità verso le generazioni a venire.

Qui si colloca il cuore del problema: non basta più discutere di applicazioni utili o di regolazioni settoriali, ma occorre immaginare forme di governance globale, consapevoli che la posta in gioco è comparabile a quella delle grandi sfide ambientali e geopolitiche.

L’etica dell’intelligenza artificiale non può limitarsi a mitigare gli eccessi narrativi, né può ridursi a una semplice lista di principi astratti. Deve porsi come un’etica della responsabilità, capace di bilanciare innovazione e prudenza. Hans Jonas, già negli anni Settanta, richiamava alla necessità di un principio di responsabilità verso il futuro: oggi quella intuizione trova una concreta applicazione nella sfida posta dall’AI.

Il compito non è demonizzare la tecnologia, ma accompagnarla con strumenti critici, normativi e culturali che ne orientino lo sviluppo. La vera questione non è se l’AGI arriverà nel 2030 o nel 2050, ma se la società sarà in grado di affrontarla con una coscienza democratica all’altezza della sfida.

La scelta degli studenti di Harvard e MIT non è un dettaglio di colore, ma un segnale epocale. Dietro quella decisione c’è la percezione di una frattura: il tempo dell’AI scorre più velocemente di quello delle istituzioni educative, politiche e normative. Il futuro, in un certo senso, bussa alla porta prima del previsto.

Il compito che ci attende è trasformare l’ansia in consapevolezza, la paura in responsabilità, l’incertezza in partecipazione collettiva. L’AI non è solo una tecnologia da costruire: è un orizzonte etico da abitare, con tutte le cautele e il coraggio che il nostro tempo richiede.