Con l’esplosione dell’intelligenza artificiale, giganti tecnologici come Google, Microsoft e Meta stanno adottando tecnologie derivate dai veicoli elettrici per trasformare i data center. L’introduzione di rack da 1 megawatt, alimentati a 400 volt in corrente continua e raffreddati a liquido, rappresenta una svolta epocale per affrontare le crescenti esigenze energetiche e termiche dell’AI.

L’intelligenza artificiale sta ridefinendo le esigenze infrastrutturali dei data center. Per gestire carichi di lavoro sempre più intensi, aziende come Google, Microsoft e Meta stanno implementando rack capaci di erogare fino a 1 megawatt di potenza. Questa evoluzione è resa possibile grazie all’adozione di sistemi a 400 volt in corrente continua, una tecnologia mutuata dai veicoli elettrici, che consente una distribuzione dell’energia più efficiente e compatta rispetto ai tradizionali sistemi a 12 V o 48 V.

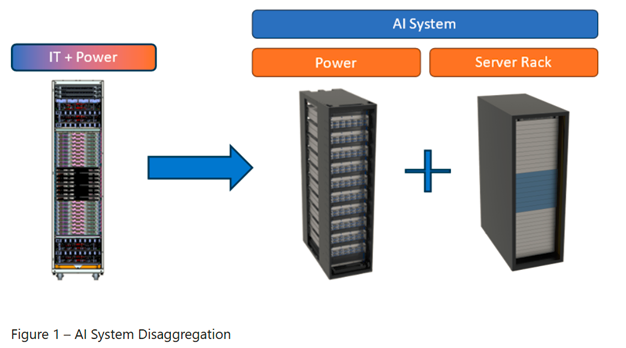

Immagine: Mt. Diablo (Microsoft)

Mt. Diablo: la nuova architettura di potenza

Il progetto Mt. Diablo, frutto della collaborazione tra Microsoft, Meta e Open Compute Project, introduce un’architettura di potenza disaggregata. Separando fisicamente i moduli di alimentazione dai rack di calcolo, questa soluzione ottimizza lo spazio e migliora l’efficienza energetica. L’adozione della tensione a 400 V c.c. permette di ridurre le perdite di conversione e di standardizzare le interfacce, facilitando l’integrazione e la manutenzione.

Il raffreddamento a liquido: una necessità, non un’opzione

Con chip AI che consumano oltre 1.000 watt ciascuno, il raffreddamento ad aria non è più sufficiente. Il raffreddamento a liquido, già utilizzato nei veicoli elettrici, offre una soluzione più efficace, grazie alla maggiore capacità termica dell’acqua rispetto all’aria. Google ha implementato questa tecnologia su larga scala, ottenendo un uptime del 99,999% su oltre 2.000 pod TPU negli ultimi sette anni.

Deschutes: il design di Google per il futuro

Il progetto Deschutes di Google rappresenta un passo avanti nell’integrazione del raffreddamento a liquido nei data center. Utilizzando piastre fredde, collettori e tubi flessibili, questo design gestisce efficacemente il calore generato dai chip AI, riducendo l’ingombro fisico e aumentando la densità di calcolo. La separazione dei circuiti di raffreddamento tra rack e struttura facilita la manutenzione e migliora l’efficienza complessiva.

Sfide e prospettive future

Sebbene l’adozione di rack da 1 megawatt rappresenti un progresso significativo, comporta anche nuove sfide. La gestione di tensioni elevate richiede rigorosi standard di sicurezza e formazione del personale. Inoltre, l’implementazione del raffreddamento a liquido comporta costi iniziali elevati e la necessità di componenti specializzati. Tuttavia, con la crescente domanda di potenza computazionale per l’AI, queste soluzioni potrebbero diventare lo standard nei prossimi anni.

Conclusione

L’integrazione di tecnologie derivate dai veicoli elettrici nei data center segna l’inizio di una nuova era nell’infrastruttura IT. Con l’adozione di rack da 1 megawatt e sistemi di raffreddamento a liquido, le aziende stanno preparando le loro infrastrutture per affrontare le sfide dell’intelligenza artificiale. Sebbene ci siano ostacoli da superare, la direzione è chiara: efficienza, scalabilità e sostenibilità saranno le parole chiave del futuro dei data center.